La fotografia computazionale è una tecnica di acquisizione ed elaborazione di immagini digitali che utilizza il calcolo digitale al posto dei processi ottici.

Il professore di Stanford e pioniere della fotografia computazionale Marc Levoy (ora è anche responsabile della macchina fotografica di Google Pixel) dà un’altra definizione: trattasi di tecniche di imaging computazionale che migliorano o estendono le capacità della fotografia digitale in cui l’output è una fotografia ordinaria, ma che non avrebbe potuto essere scattata da una macchina fotografica tradizionale.

Tradotto in soldoni, la fotografia computazionale esiste perché esistono gli Smartphone, o meglio…è colpa degli smartphone: questi apparecchi non avevano altra scelta se non quella di dare vita a un nuovo tipo di fotografia, la fotografia computazionale, appunto.

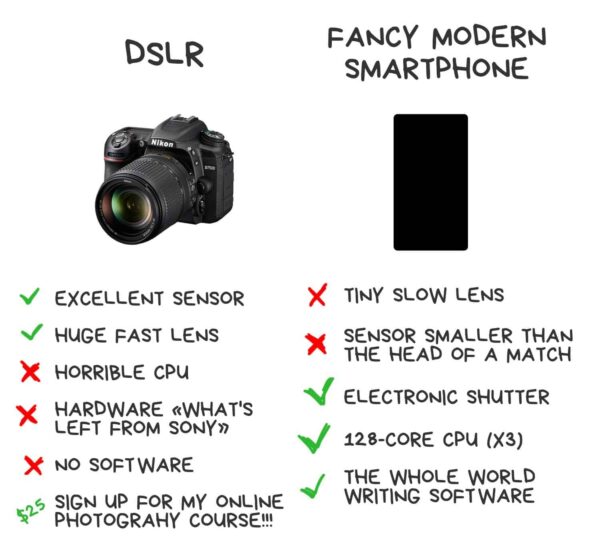

Gli smartphone hanno dei sensori poco rumorosi e delle lenti lenti minuscole. Secondo tutte le leggi della fisica, non potevano che portarci dolore e sofferenza…ed è stato così al principio. O almeno finché alcuni sviluppatori non hanno capito come usare i loro punti di forza per superare le debolezze: otturatori elettronici veloci, processori potenti e software, tanto tanto software.

Questo tipo di fotografia non è solo il bokeh: la fotografia recente pubblicata di un buco nero non sarebbe stata scattata senza l’uso di metodi di fotografia computazionale (per rendere l’idea, per scattare una foto del genere con un telescopio standard, dovremmo renderla grande come la Terra). Tuttavia, combinando i dati di otto radiotelescopi in diversi punti della nostra palla di terra e scrivendo alcuni fantastici script Python, abbiamo ottenuto la prima immagine al mondo dell’orizzonte degli eventi. Questa è la fotografia computazionale.

Cos’è la fotografia computazionale?

La fotografia computazionale è una tecnica di acquisizione ed elaborazione di immagini digitali che utilizza il calcolo digitale al posto dei processi ottici.

I computer in fotografia non sono una novità. Ogni macchina fotografica dell’era digitale richiede una potenza di elaborazione per creare l’immagine. Già prima dell’alba del digitale, i processori venivano utilizzati nelle macchine fotografiche a pellicola: essi controllavano cose come le modalità di esposizione automatica, la messa a fuoco automatica e la potenza del flash.

Oggi, i computer delle nostre fotocamere sono estremamente potenti. Possono analizzare il tipo di scena davanti al nostro obiettivo, la velocità e la direzione di un soggetto tracciato e persino agganciare l’occhio di un soggetto. Sono davvero incredibili. Tuttavia, per quanto siano bravi e potenti i nostri processori, stanno semplicemente aiutando la nostra fotografia.

Ci sono diverse definizioni di fotografia computazionale, ma per dirla in parole povere, è quando una macchina fotografica usa la potenza di elaborazione per superare i limiti del suo hardware. Più comunemente, quell’hardware è il sensore o l’obiettivo.

Il potenziale della fotografia computazionale è noto da tempo. Tuttavia, è solo negli ultimi anni che la potenza di elaborazione è diventata abbastanza potente da poterla raggiungere. Abbiamo usato per anni i nostri processori per computer portatili e desktop per ottenere la fotografia computazionale in post-produzione, ma ora le cose stanno cambiando.

Esempi classici sono l’HDR, la fotografia ad alta gamma dinamica e la riduzione del rumore. Abbiamo scritto parecchi articoli su come scattare più immagini può ridurre drasticamente il rumore nei vostri scatti. La differenza oggi è che le nostre fotocamere possono farlo in tempo reale, senza che sia necessario tornare al computer, caricare gli scatti ed elaborarli in un’applicazione di editing.

C’è un genere che guida la fotografia computazionale più di ogni altro ed è quello degli smartphone. Vediamo a che punto siamo oggi.

Fotografia computazionale oggi

Nel settembre 2019, Apple ha annunciato l’iPhone 11 Pro. Il soprannome Pro dedusse che il loro nuovo smartphone era uno strumento fotografico professionale. Questo, come per la maggior parte dei prodotti Apple, è stato accolto con pari misura di derisione e di intrigo, soprattutto dal mondo fotografico.

Come spesso accade con i prodotti Apple, ciò che hanno offerto ai fotografi nell’iPhone 11 Pro non era né rivoluzionario né nuovo. Era, tuttavia, dato il trattamento Apple. Vale a dire, è stato reso sia molto utilizzabile che di alta qualità. La forza trainante che rende l’iPhone 11 Pro così intrigante è il suo potenziale attuale e futuro per la fotografia computazionale.

Le fotocamere degli smartphone sono migliorate in modo quasi esponenziale. Le uscite annuali di Apple, Samsung, Google, Huawei e altri hanno aggiunto alcune caratteristiche incredibili al mondo della fotogragia digitale…pensiamo proprio ai prodotti Huawei che stanno sempre più puntando (come il P30 pro) a sostituire le tradizionali macchine fotografiche compatte.

Le loro macchine fotografiche, tuttavia, sono state e saranno per il prossimo futuro limitate dalle dimensioni fisiche del telefono. Questo significa sensori molto piccoli, lenti molto piccole e tutti i problemi tecnici che ne derivano.

I fotografi di smartphone non vogliono rinunciare al design ultra sottile e compatto dei loro dispositivi, ma vogliono essere in grado di ottenere l’aspetto di macchine fotografiche più grandi. Questo è uno dei principali fattori che guidano lo sviluppo della fotografia computazionale.

HDR, Bokeh e Stabilizzazione.

Questi sono i tre punti cardine della fotografia computazionale al giorno d’oggi. Recentemente sono state affiancate da modalità in bianco e nero e notturne di alto livello. Queste ultime dimostrano come il potere dei processori stia diventando sempre più importante in fotografia. Ma come funzionano?

Come fotografi siamo generalmente abituati all’approccio a scatto unico. Premiamo l’otturatore, scattiamo un solo scatto e poi premiamo di nuovo l’otturatore. Anche i modi continui più veloci funzionano in modo simile. Continuano semplicemente a scattare singoli scatti fino a quando non rilasciamo il pulsante di scatto.

Nella fotografia computazionale, quando premiamo l’otturatore, la fotocamera scatta più immagini praticamente simultaneamente. Elaborerà poi queste immagini in tempo reale in un unico scatto. L’HDR è la forma più semplice di tutto questo ed è in circolazione da un po’ di tempo. La fotocamera prende una staffa di 5-6 scatti e li fonde immediatamente. Si tratta di un processo relativamente semplice che non richiede una grande potenza di elaborazione.

Passiamo però a Bokeh e vediamo quanto sono potenti gli smartphone moderni. Bokeh nella fotografia basata sulla fisica richiede sensori di grandi dimensioni e un’ampia apertura, lenti veloci di almeno una lunghezza focale moderata. Chiaramente qualcosa di impossibile in un telefono.

Per contrastare questo lo smartphone prende più immagini, ognuna concentrata su un dettaglio tecnico specifico. Per esempio, potrebbero essere necessari scatti per controllare l’esposizione, la messa a fuoco, il tono, i riflessi, le ombre e il riconoscimento del volto. Poi le fonde, analizzando tutti i dati all’interno di ogni scatto e cercando di mascherare il soggetto dallo sfondo. Aggiungerà poi una sfocatura a quello sfondo per simulare Bokeh. Tutto questo viene fatto virtualmente in tempo reale.

Le modalità notturne e i filtri a chiave alta utilizzano tecniche simili ad alta intensità di processore. E questi sono solo l’inizio.

Il futuro della fotografia computazionale

La DSLR è morta, è il grido di molti siti web di fotografia di questi tempi. E ad essere onesti, sono quasi certamente corretti. Tuttavia, non per i motivi che ci si potrebbe aspettare. Le dimensioni, le capacità video e molte altre ragioni sono state suggerite per spiegare perché le aziende si stanno spostando verso il mirrorless, ma questa non è la storia completa.

Il motivo per cui aziende del calibro di Nikon, Canon, Sony e Panasonic si stanno lanciando nel mirrorless è il loro potenziale di utilizzare la fotografia computazionale.

L’handicap principale che trattiene la DSLR è lo specchio. Nelle fotocamere mirrorless non ci sono ostacoli al sensore. Ecco perché può alimentare in diretta un’immagine direttamente dal sensore all’LCD o al mirino. Questo, a sua volta, significa che può analizzare una scena dal vivo, ben prima di premere l’otturatore e questo rende la fotografia computazionale una possibilità reale nelle fotocamere mirrorless.

Cosa li trattiene, dunque? L’unico motivo per cui al momento non abbiamo molta fotografia computazionale in mirrorless è lo stesso motivo per cui l’abbiamo negli smartphone, la potenza di elaborazione. La quantità di dati che viene estratta dai sensori del sistema compatto è molto più grande che negli smartphone e queste fotocamere hanno la potenza di elaborazione solo per tecniche limitate.

Questo però sta cambiando rapidamente e se volete vedere come, basta guardare indietro alle capacità video degli ultimi anni. Qualche tempo fa, il formato video standard per le videocamere fisse era 1080p a 24fps. Ora la maggior parte delle nuove videocamere scatta a 4k a 60fps. È un salto di qualità nella potenza di elaborazione e in pochi anni. La fotografia computazionale per le fotocamere mirrorless sta bussando alla porta e quella porta sarà aperta molto presto.

È un imbroglio, vero?

Ci sarà una ricca vena di puristi che non saranno contenti della fotografia computazionale. È barare che piangeranno, non è la fotografia pura che potrebbero dire. Ma naturalmente lo stesso tipo di persone ha detto le stesse cose quando la fotografia è passata dal vetro alla celluloide, dal bianco e nero al colore e dalla pellicola al digitale. Il fatto è che la fotografia è una tecnologia in continua evoluzione e lo sarà sempre. I migliori fotografi sono sempre stati quelli che rispettano e comprendono il passato, ma sono anche felici di abbracciare il futuro.

Ulteriori approfondimenti circa la fotografia computazionale

Ora, venendo ai dettagli della fotografia computazionale, bisogna dire che non esistono molti lavori “completi” e al contempo comprensibili. Tranne forse uno, nel quale mi sono recentemente imbattuto, realizzato da Vasily Zubarev: una guida (o enciclopedia) ben più che completa e particolareggiata di cui vi risporto di seguito l’indice. Unico “problema” è che il tutto è in inglese.

- Per cominciare: processo digitale

- Math e Instagram

- Automazione e il sogno di un pulsante che realizza il capolavoro

- Lo Staking

- Lo Staking dell’esposizione

- Lo Staking temporale

- Lo staking del movimento

- Lo staking del focus

- I sensori computazionali

- Fotocamera plenottica

- Light field

- Ottica computazionale

- Luce computazionale

- Il futuro?

- Gli smartphone moderni e la fotografia computazionale

Conclusione

Nel corso della storia, ogni tecnologia umana diventa più avanzata non appena smette di copiare gli organismi viventi. Oggi è difficile immaginare un’auto con articolazioni e muscoli al posto delle ruote. Gli aerei con le ali fisse volano a 800+ km/h – gli uccelli non ci provano nemmeno.

E lo stesso vale per la fotografia, o meglio pse il sensore: fino ad oggi non abbiamo fatto nulla che imitare la struttura dell’occhio. O meglio, fino a ieri: questo perché oggi la fotografia computazionale ha aggiunto un “cervello” al processo. Un processore che gestisce le informazioni visive non solo leggendo i pixel attraverso il nervo ottico, ma anche completando l’immagine in base alla sua esperienza.Non è una rivoluzione, ma probabilmente è l’inizio della rivoluzione stessa.

Aggiornato Maggio 2021